前言与背景

随着科学技术的不断发展,锂离子电池快充策略逐渐在减少充电时间、缓解电动汽车的里程焦虑以及优化电动汽车车队经济性中发挥出重要作用。然而,使用过大电流对电池进行快速充电可能会导致电池寿命降低;若是激进充电,甚至可能带来包括火灾和爆炸在内的重大安全风险。为了能够在减少充电时间的同时保证电池的安全性、防止电池退化,科学家们设计出了多种针对电池的快充策略,且大致可分为三类:临时方法、基于模型的方法和数据驱动方法。其中,临时方法通常不需要复杂的模型或算法,而是依赖于一些基本的充电原则和经验规则,但过于保守,无法达到最优;基于模型的方法通过模拟电池的物理和化学过程来预测电池在不同充电策略下的行为,从而优化充电协议,但受限于电池模型复杂性,也无法保证充电策略的最优性;与前两者相比,数据驱动的方法在设计电池快充策略时避免依赖传统的物理模型,通过机器学习和深度强化学习(DRL)分析大量的电池充电数据以获得最优充电曲线。通过结合DRL,该方法可以适应性地学习最优充电协议,并随着电池老化和参数漂移而调整,因此受到广泛关注。然而,如今大多数研究通过在奖励中使用软惩罚来处理约束违规,因此无法在整个充电过程中严格确保约束满足,可能导致电池寿命降低或安全风险。目前,有以下问题亟待解决:(1)优化策略能够实时适应不同操作条件,实现快速充电;(2)寻找最优充电策略时,同时满足电池的安全和性能限制。

研究内容

1. 主要方法

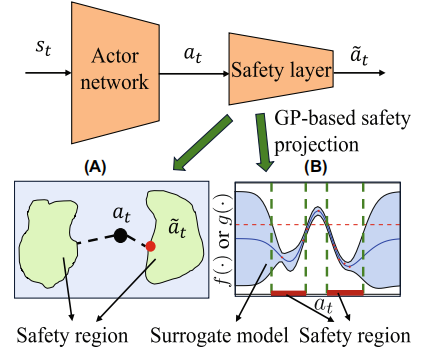

为了实现快速充电过程的安全,该论文提出以双延迟深度确定性策略梯度(TD3)作为RL算法的框架,在策略优化过程中,将安全约束纳入奖励函数,通过设计合理的奖励和惩罚机制,引导智能体在保证安全的前提下实现充电效率的最大化,从而优化电池快速充电协议,确保在高概率下满足安全约束;不仅如此,作者们利用自适应高斯过程(GP)模型自适应学习约束函数,先是统一收集前m个批次的数据训练一个静态的GP,m个批次后,每批次更新一个动态的GP,即通过当前的原始动作来预测下一步的电压或温度,如果超过预设范围,则将这个动作映射到安全的动作范围,从而实时适应电池状态和外部环境变化;在此基础上,论文还通过引入行动投影机制,当RL智能体选择潜在危险动作时,将其投影到安全区域,确保每一步充电动作的安全性。该研究巧妙地结合了静态GP和自适应GP的各自优势。他们先利用静态GP初步约束建模,提供基础预测;再利用自适应GP实时更新和调整,从而确保在动态变化的环境中,安全行动投影机制能有效应对潜在的风险,大大提高充电过程中的安全性。这项成果为电池快速充电技术的安全性和效率提供了创新的解决方案,同时为相关领域的研究和应用奠定了基础。

图1 基于行动投影的安全强化学习示意图

该项研究工作的主要贡献是提出了基于动作投影的安全强化学习方案,其基本原理如图1所示。为了确保安全,在奖励函数设计上,提出将充电效率奖励与安全惩罚相组合,设计出如下即时奖励函数

该奖励函数中包含对违反安全约束的惩罚项。其中第一项是对充电时间的惩罚,第二项和第三项是对违反电压和温度限制的惩罚。如果智能体的行为导致电池的温度、压力或电压超出安全限制,则相应的奖励会降低。这种惩罚机制促使智能体在学习过程中权衡充电速度与安全性,从而在尽可能快地充电的同时,保证关键过程变量不违反安全约束。

2. 实验验证

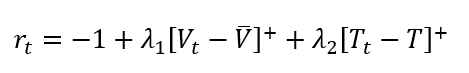

2.1 在固定条件下对电池电压、温度和电流的控制

基于本文提出的自适应安全强化学习框架,在环境温度为25℃,充电电流∈[0.05C,4.5C](其中C为充电速率),采样时间为10秒的固定条件下,分别测量利用传统TD3、安全TD3和自适应安全TD3框架将电池电量从10%充至80%时的电压、温度和电流曲线,并将三者进行比较。

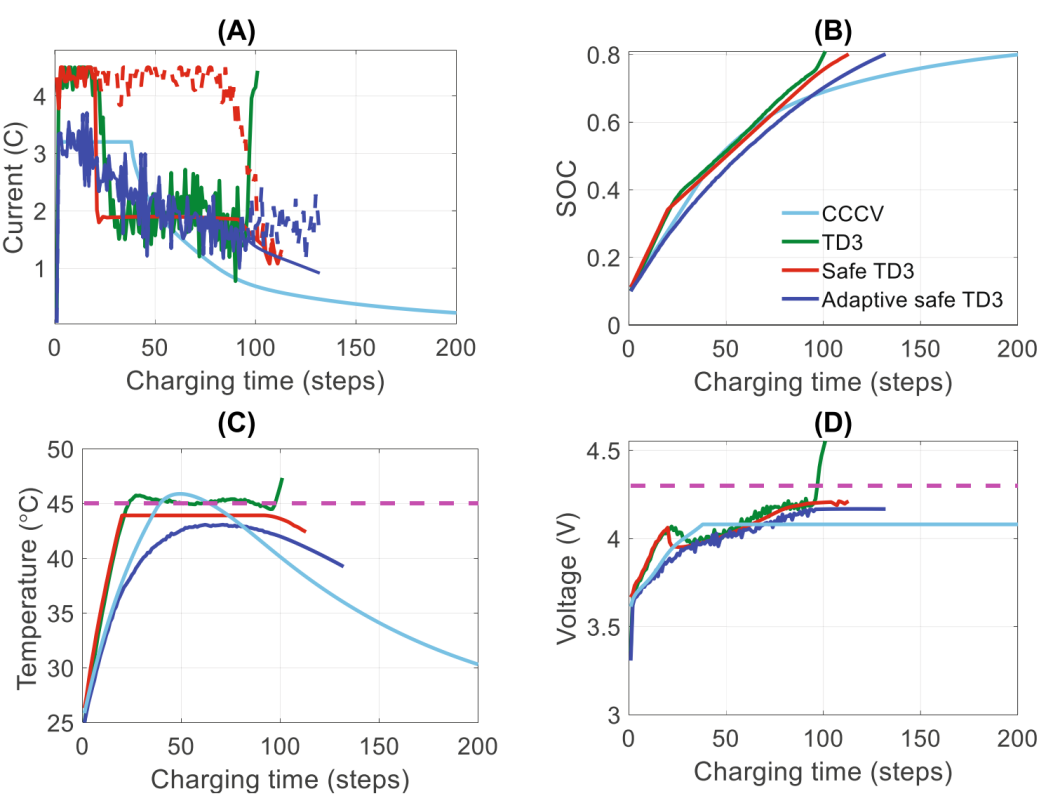

在对电压和温度的控制方面,实验结果如图2所示,从图中可以看出,相比于传统TD3而言,安全TD3和自适应安全TD3极好的将温度和电压控制在了标准线以下,很好的防止了温度和电压违规。而自适应安全TD3的控制程度更是明显胜于安全TD3。

图2 传统TD3(绿色)、安全TD3(红色)和自适应安全TD3(蓝色)在优化电池快速充电协议中的训练表现

在对充电曲线的控制方面,传统TD3以严重违反约束条件(紫色虚线)为代价达到较短的充电时间(见图3 (c)-(d));而恒流恒压方法(CCCV)尽管满足了运行条件,但该方法为电池充电所需的时间远远长于上述三种RL方法,从高效率的角度上来说也并不可取;相较于前两者,安全TD3在20个充电步骤后开始将电流投射到安全区域,以确保不违反约束条件;而由于自适应安全TD3(蓝色)只需要在最后30个阶段进行动作预测,最终电流预案比安全TD3更为保守。

图3 部署传统TD3(绿色)、安全TD3(红色)、自适应安全TD3(蓝色)和经典CCCV(蓝色)的优化协议后所得的相应曲线

实验结果表明,在固定环境下,自适应安全强化学习框架可以很好的限制电压、温度和电流,保证快速充电时的安全性。

2.2 在不同条件下对电池快速充电性能的优化

相比于静态 GP 无法捕捉电池动态的变化,采用自适应高斯过程模型的策略,能够在线学习新的电池动态,使其即使在环境动态发生漂移时也能确保满足约束条件,从而对不同条件下的电池动态进行了很好的捕捉。

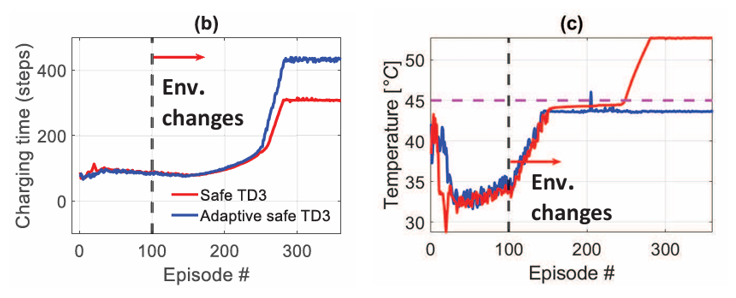

为了验证该性能,论文首先进行环境条件变化和电池电量下降时的训练实验。实验结果表明,随着环境温度不断升高,系统动态发生重大变化,电池迅速老化,安全TD3无法适应新的条件,违反了温度约束,导致其回合奖励大幅下降;与之相比,而自适应安全TD3通过降低电流强度,延长充电时间的方式,确保限制条件,保证了充电时的安全性(如图4所示)。

图4 用于优化电池快速充电协议的安全(红色)和自适应安全(蓝色)TD3 的训练性能

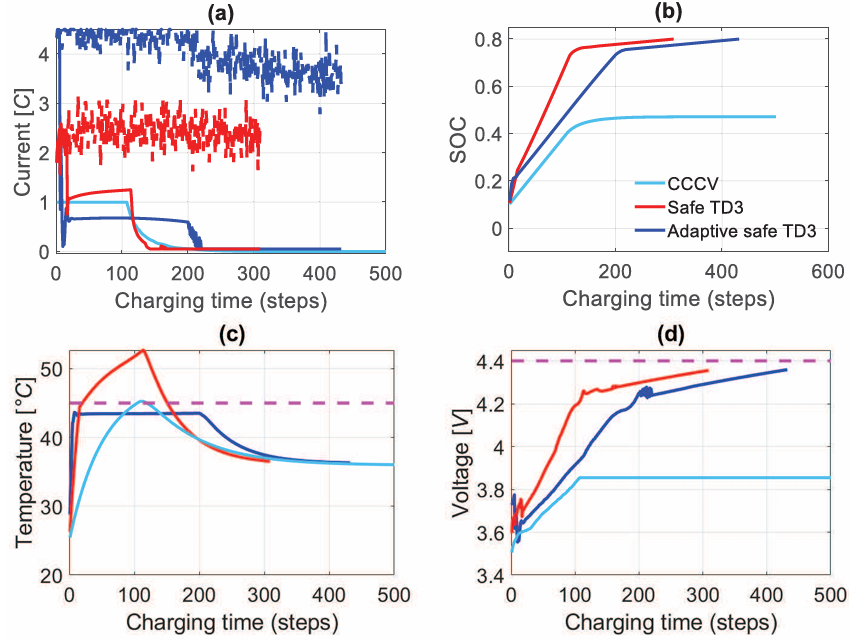

然后是对充电电流进行优化训练。结果如图5所示,可以看出,对于CCCV充电协议,无论充电时间长短,最终协议都无法达到80%SOC的目标,无法应对高温和电池衰减等恶劣环境条件;此外,随着环境温度的升高和电池的老化,安全TD3中的静态GP无法正确构建新的安全区域,导致动作减少不足,进而违反了温度约束(如图5(c)中所示);相比之下,自适应安全TD3可以在线学习新的系统动态,准确构建更新的安全区域,并正确预测动作,以同时遵守温度和电压约束(如图5(c)-(d)所示)。

图5 根据安全TD3(红色)、自适应安全TD3(蓝色)和经典CCCV(蓝色)的优化协议得出的最优曲线

总结

总的来讲,本论文提出了一种自适应安全的强化学习框架,用于优化电池快充协议。这个框架通过在行动决策后添加安全层的方式,确保行动在安全区域内;不仅如此,本文使用自适应高斯过程模型来模拟电池的安全约束,并根据电池动态变化进行调整,并通过模拟验证了该方法在不同条件下的有效性。实验结果表明,该方法能够在保持安全的同时实现了快速充电。这种方法不仅适用于电池快充,还可以推广到其他需要严格安全约束的场景。例如,电池种类方面,未来的研究可以扩展到不同类型的真实电池,如固态电池、镍氢电池等的快速充电优化;GP模型方面,未来的研究可以考虑通过多步预测,或者和其他机器学习模型(如强化学习、深度学习等)进行集成,以提升整体性能和准确性。

通过这篇文献,我们注意到高斯过程(GP)模型在不确定性建模中的重要作用,比如在动态环境下,可以通过利用GP预测约束条件的方式提高预测的准确性和可靠性;也明白了设计奖励函数时需要考虑多方面因素,使其既能够激励高效操作,又能惩罚不安全行为,从而保证效率和安全并行;此外,该文献也让我们看到化学工程和控制、AI等多个领域的交叉运用,通过多学科合作的方式,可以更具效率的解决所遇到的工程问题。

原文链接:https://aiche.onlinelibrary.wiley.com/doi/10.1002/aic.18605

编辑:刘玉研